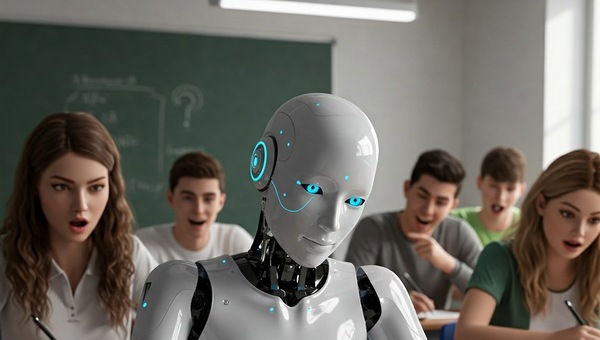

Model od OpenAI poradził sobie celująco, uzyskując 94% możliwych punktów. Jak podkreśliła egzaminatorka:

"Praca była spójna, logiczna i wykraczała poza standard uczniowski. Gdybym nie wiedziała, że to AI, uznałabym, że to bardzo dobrze przygotowany maturzysta." -

Drugi na podium Claude zdobył 91%, co również zasługuje na wysoką ocenę. Była to praca "bardzo dobra", choć – jak zauważono – momentami brakowało oryginalności lub głębi w interpretacji. Mimo to, wynik imponujący jak na cyfrowego ucznia.

Na trzecim biegunie – model DeepSeek, który zdobył jedynie 20% punktów. Praca została oceniona jako niepoprawna zarówno pod względem językowym, jak i merytorycznym. Zdaniem ekspertów, tekst „nie spełniał podstawowych kryteriów maturalnych”.

Jak komentuje nauczycielka polskiego:

Dwie z trzech prac przewyższają poziomem to, z czym najczęściej mamy do czynienia przy ocenie prac maturalnych. AI nie tylko rozumie polecenie, ale także potrafi je zrealizować w logiczny i dojrzały sposób.

To oznacza jedno: AI nie tylko rozumie „Pana Tadeusza”, ale też wie, jak go umiejętnie przytoczyć. Przynajmniej niektóre modele.

Klucz leży w danych treningowych i architekturze modelu. Zarówno ChatGPT, jak i Claude, były szkolone na ogromnych zbiorach tekstów literackich i akademickich, co pozwoliło im operować językiem na wysokim poziomie. DeepSeek – choć szybko zdobywa popularność w Azji – nie został jeszcze dostrojony do specyfiki zadań maturalnych czy polskiej literatury.

Ten eksperyment to nie tylko ciekawostka, ale też początek ważnej rozmowy o roli AI w edukacji. Czy uczniowie będą korzystać z takich narzędzi? Tak. Czy szkoły powinny uczyć, jak to robić mądrze i etycznie? Zdecydowanie tak.

Bo choć sztuczna inteligencja może pomóc napisać wypracowanie, to jeszcze nie zastąpi refleksji, jaką daje prawdziwe zrozumienie tekstu – i życia.