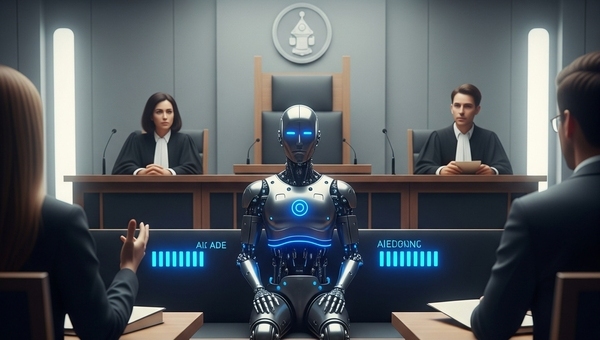

Brytyjski sędzia wydał oficjalne ostrzeżenie: jeśli prawnicy będą powoływać się na precedensy stworzone przez sztuczną inteligencję, które nigdy nie miały miejsca w rzeczywistości, muszą się liczyć z konsekwencjami dyscyplinarnymi.

„To nie jest tylko nieprofesjonalne. To wprowadza w błąd sąd, podważa zaufanie do systemu i może poważnie zaszkodzić sprawiedliwości” – powiedział anonimowo jeden z sędziów apelacyjnych, cytowany przez The Guardian.

A takich przypadków jest coraz więcej. AI, choć potężna i użyteczna, ma tendencję do tzw. halucynowania – czyli generowania przekonujących, ale całkowicie fikcyjnych informacji. W tym przypadku: wyroków, które nigdy nie zapadły.

Korzystanie z narzędzi AI w środowisku prawniczym nie jest zabronione – wręcz przeciwnie, wiele kancelarii już wykorzystuje je do szybszej analizy dokumentów, wyszukiwania przepisów czy przygotowywania wstępnych szkiców pism.

Ale – i to wielkie ale – prawnik odpowiada za każde słowo, które składa przed sądem. A jeśli „słowo” pochodzi z AI i jest nieprawdziwe, problem spada właśnie na niego.

To trochę jak z GPS-em: możesz go używać, ale jeśli wjedziesz do rzeki, to ty – a nie satelita – ponosisz odpowiedzialność.

Zjawisko to zyskało już własną nazwę – AI hallucinations in law – i staje się poważnym wyzwaniem dla sądownictwa na całym świecie. W USA głośno było o sprawie dwóch prawników, którzy zostali ukarani za przedstawienie sądowi sześciu fikcyjnych precedensów wygenerowanych przez ChatGPT.

Brytyjski wymiar sprawiedliwości chce działać zawczasu, zanim AI przekształci się w narzędzie chaosu. Sugerowane są nowe przepisy regulujące korzystanie z modeli językowych w pracy prawnika – od obowiązkowego oznaczania treści generowanych przez AI po wymóg ręcznej weryfikacji każdego użytego źródła.

Czy AI zniknie z sal sądowych? Niekoniecznie. Ale z pewnością zmieni zasady gry. Prawnicy będą musieli łączyć technologię z odpowiedzialnością, a sądy – nauczyć się odróżniać prawdę od syntetycznej fikcji.

Bo jak powiedział jeden z ekspertów ds. prawa cyfrowego:

"Nie chodzi o to, by zakazać AI. Chodzi o to, by nie pozwolić jej zastąpić prawdy." -

Podsumowanie: W erze, gdzie nawet precedensy mogą być deepfake’ami, prawnicy muszą mieć więcej niż tylko aplikację na smartfonie – muszą mieć sumienie, rozum i… solidne źródła.

Jeśli jesteś prawnikiem, sędzią albo po prostu użytkownikiem AI – pamiętaj: technologia to narzędzie, ale prawda nadal ma pierwszeństwo przed algorytmem.

Chcesz więcej newsów z pogranicza prawa, AI i rzeczywistości? Obserwuj bloga i nie daj się złapać w cyfrową pułapkę!