Zdarza się, że czytając o AI natrafiamy na informację, że np. Gemini Advanced pozwala na obsługę 2 milionów tokenów, ChatGPT Plus ma limit 64 000 tokenów. Tylko co to znaczy? Wyjaśniamy.

Token w AI jest jak mała paczka informacji, traktowana jako całość. Taki atom informacyjny. Token może reprezentować słowa, znaki lub nawet całe frazy. Na przykład podczas przetwarzania tekstu zdanie jest dzielone na tokeny, gdzie każde słowo lub znak interpunkcyjny jest uważany za oddzielny token. Ten proces tokenizacji jest kluczowym krokiem w przygotowywaniu danych do dalszego przetwarzania w procesach modelu AI.

Dla chatbota każde słowo w danych wejściowych użytkownika jest traktowane jako token AI, co pomaga AI zrozumieć i odpowiednio zareagować. Ważne jest również liczenie tokenów w tekście w celu oszacowania czasu i kosztów przetwarzania, ponieważ różne metody tokenizacji mogą wpływać na ich liczbę.

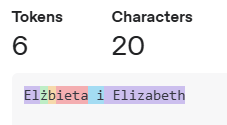

Poniżej przykład podziału tekstu na tokeny przez GPT-4

Zwróćcie uwagę na ostatnie zdanie i podział w nim na tokeny. W słowie Łódź widzimy nieprzypadkowo 3 kolory. Wniosek jest taki, że język i zastosowane w nim znaki specjalne mogą mocno wpływać na ilość tokenów a co za tym idzie na szybkość i koszt ich przetwarzania.

Jeżeli płacimy za każdy przekazany token x PLN, to zobaczmy ile kosztuje nas zapytanie o dwie siostry, o prawie tym samym imieniu. Taniej będzie pytać o siostrę z zagranicy.

Tokeny AI nie są ograniczone wyłącznie do tekstu. Mogą reprezentować różne formy danych i odgrywać kluczową rolę w zdolności AI do ich rozumienia i uczenia się z nich. Na przykład w komputerowym widzeniu token AI może oznaczać segment obrazu, taki jak grupa pikseli lub pojedynczy piksel.

Podobnie w przetwarzaniu dźwięku, token może być fragmentem dźwięku. Ta elastyczność tokenów AI sprawia, że są one niezbędne w zdolności AI do interpretowania i uczenia się z różnych form danych. Zrozumienie limitów tokenów AI jest również kluczowe dla optymalizacji opłacalności i wydajności funkcjonalnej wdrożeń AI.

Tokeny są podstawą sposobu, w jaki generatywne modele sztucznej inteligencji interpretują dane wejściowe, przewidują dane wyjściowe i utrzymują kontekst w ustalonym oknie kontekstowym.

Typowy proces jest następujący:

- Tokenizacja AI: Model dzieli tekst wejściowy na tokeny AI, które mogą być całymi słowami, podsłowami lub pojedynczymi znakami, w zależności od tokenizacji. Ten proces jest kluczową częścią przetwarzania języka naturalnego (NLP), w którym tekst jest dzielony na mniejsze jednostki zwane właśnie tokenami.

- Osadzanie: Każdy token w AI jest konwertowany na wektor liczbowy, i dopiero wtedy model AI może go przetworzyć.

- Przetwarzanie i przewidywanie: Model przewiduje następny token AI na podstawie rozkładów prawdopodobieństwa, generując treść krok po kroku.

- Dekodowanie i dane wyjściowe: Model wybiera najbardziej prawdopodobną sekwencję tokenów AI i konwertuje ją z powrotem na tekst czytelny dla człowieka lub inne formy treści.

Czyli AI to takie pudełko, do którego z jednej strony mamy odpowiednio przycięte otwory przepuszczające tylko przygotowane wcześniej kształty (tokeny) w odpowiedniej kolejności. Z drugiej strony pudełka jest to samo, tylko odwrotnie. A w środku, programistyczne czary mary.

Rodzaje tokenów w generatywnej AI

- Tokeny tekstowe: używane do generowania odpowiedzi przypominających ludzkie w aplikacjach, takich jak chatboty, asystenci pisania i narzędzia do generowania kodu.

- Tokeny obrazu: stosowane w modelach takich jak DALL·E i Stable Diffusion, w których obrazy są rozbijane na struktury przypominające tokeny w celu generowania obrazów.

- Tokeny audio: wykorzystywane w modelach głosu AI

Dlaczego tokeny mają znaczenie w generatywnej AI? Odpowiedzią jest koszt i wydajność: Modele AI często pobierają opłaty na podstawie wykorzystania tokenów. Więcej tokenów AI oznacza wyższe koszty obliczeniowe. Zrozumienie limitów tokenów jest ważne, ponieważ mają one bezpośredni wpływ na koszty operacyjne i wydajność.

Ma to też wpływ na rozwój AI. Deweloperzy optymalizują modele, dostosowując sposób przetwarzania tokenów AI, zwiększając płynność i trafność.